A napokban, ahogy az a jól megszokott menetrend szerint várható is volt a Red Hat hivatalosan is bejelentette az OpenShift 4.19 általános elérhetőségét, amely jelentős újdonságokat hoz a virtualizáció, a vállalati mesterséges intelligencia (AI), valamint a biztonság és a felhőalapú integráció terén.

Az OpenShift 4.19 meghatározó technológiai komponensként a Kubernetes 1.32 és a CRI-O 1.32 alapjaira épül. Az új verzió jelentős előrelépést hoz a robusztus AI workloadok, a virtualizáció és a biztonság területén, miközben továbbra is támogatja a Red Hat OpenShift Platform Plus-t. Az OpenShift 4.19 egy megbízható, átfogó és konzisztens alkalmazásplatformot kínál, lehetővé teszi a vállalatok számára, hogy biztonságot érintő kompromisszumok nélkül valósítsanak meg igen gyors innovációt a hibrid felhő környezetekben. A platform átfogó eszközkészletet biztosít a felhőnatív, AI, virtuális és hagyományos workloadok kezelésére egyaránt.

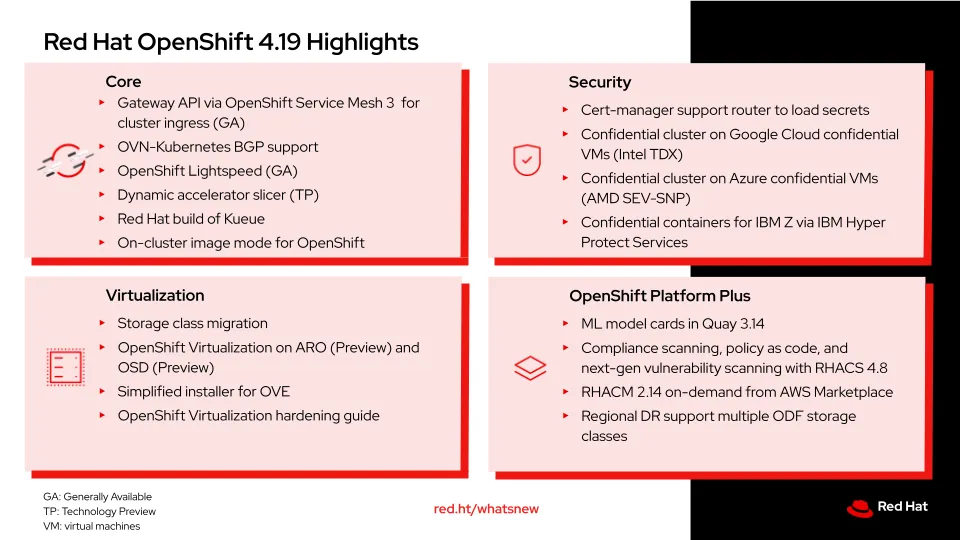

Az alábbiakban bemutatjuk az OpenShift 4.19 legfontosabb újdonságait és fejlesztéseit.

Természetes nyelvi hibaelhárítási támogatás és AI integráció

Az OpenShift 4.19 fontos újdonsága a Red Hat OpenShift Lightspeed, egy generatív AI-alapú virtuális asszisztens, ami jelentősen javítja a hatékonyságot és az üzemeltetési folyamatokat az OpenShift környezetekben. A funkció lehetővé teszi a természetes nyelvi interakciót, így a kevésbé tapasztalt felhasználók is gyorsabban eligazodhatnak, míg a tapasztalt szakemberek hatékonyabban végezhetik feladataikat, ezáltal több idő juthat az innovációra. Az OpenShift Lightspeed különösen hasznos a virtualizációs feladatok során, például a virtuális gépek (VM) migrációjának és modernizációjának egyszerűsítésében, mivel azonnali válaszokat kínál virtualizáció-specifikus kérdésekre (is).

Az OpenShift 4.19 rugalmas integrációt kínál több AI-modellszolgáltatóval, például az OpenAI, az Azure OpenAI és az IBM WatsonX platformokkal, valamint technológiai előzetesként elérhető a klaszterinterakció és a "Bring Your Own Knowledge" integráció, amely lehetővé teszi a szervezetek saját dokumentációjának testreszabott használatát. Az OpenShift AI-al kombinálva a platform teljes körű gépi tanulási műveleteket (MLOps) támogat, beleértve a modellfejlesztést, -tanítást, -finomhangolást, a generatív AI-t és egyéb AI munkaterheléseket kezdve a helyi (on-prem) környezetekről a különböző felhőplatformokon át az egészen a perem (edge) környezetekig.

OpenShift Virtualization fejlesztések

Az OpenShift Virtualization egy jó ideje az OpenShift platform alapértelmezett része. Az új kiadásban továbbfejlesztett támogatást nyújt a virtuális gépek kezelésére és migrációjára. A megoldás egyszerűsíti a hagyományos virtuális gépek migrációját más platformokról, például VMware vagy Red Hat Virtualization környezetekből, miközben korszerű, konténer-alapú üzemeltetési környezetet biztosít. Az OpenShift Virtualization a Kubernetes-alapú KubeVirt technológiára épül, ami lehetővé teszi a virtuális gépek és konténerek együttes kezelését ugyanazon a platformon, így növelve az üzemeltetési hatékonyságot és csökkentve a költségeket.

Lehetővé vált a virtuális gépek migrálása különböző storage class-ok között egy klaszteren belül, ami jelentősen egyszerűsíti a tömeges VM migrációkat. Az OpenShift Virtualization mostantól szinte bármely nagyobb felhőszolgáltatón vagy on-premises környezetben futtatható, és egyszerűsödött a telepítési folyamat is

Hálózati fejlesztések

Az OpenShift 4.19 kiterjeszti a Border Gateway Protocol (BGP) támogatását a platform alapvető hálózati funkcióiba, lehetővé téve a pod- és virtuálisgép-hálózatok útvonalainak importálását és hirdetését külső BGP-partnerek számára. Ez a funkció közvetlen integrációt biztosít a szolgáltató hálózati infrastruktúrájával, és a VRF-Lite támogatással kombinálva lehetővé teszi a szolgáltatói VPN-ek kiterjesztését az OpenShift klaszterekbe. A BGP-támogatás magában foglalja a kétirányú fowarding-detektálást (BFD), ami hálózati eszközök közötti kapcsolati problémák gyors felismerését szolgálja, ezáltal gyorsan felismerhető, ha egy kapcsolat vagy az eszközök közötti útvonal nem működik, illetve lehetővé teszi a routing- és forwarding információk kiigazítását.

On-cluster image mód

Az OpenShift 4.19 új, on-cluster image módja nagyobb kontrollt biztosít a klaszter node-jai felett. Ez a funkció lehetővé teszi testreszabott operációsrendszer-képek létrehozását és használatát a klaszteren belül, ahol a Red Hat Enterprise Linux CoreOS (RHCOS) úgy kezelhető, mint egy konténer, kód alapon leírható és buildelhető, valamint egységesen telepíthető a teljes OpenShift infrastruktúrán. A képesség lehetővé teszi, hogy akár nem konténerizált agent-eket, speciális hardvergyorsító- és/vagy monitorozó eszközöket adjunk hozzá a Core OS-hez (RHCOS), miközben a testreszabásokat a klaszterfrissítéseken keresztül rendszer továbbra is biztosítja.

Gateway API és OpenShift Service Mesh 3

Az OpenShift 4.19-ben a Service Mesh 3-mal általánosan elérhetővé vált a Gateway API, ami egységes és kiterjeszthető ingress menedzsmentet biztosít. Ez a megközelítés lehetővé teszi a forgalom rugalmas, szerepkör-alapú irányítását, L4/L7 szintű terheléselosztást és TLS-terminálást, valamint dinamikus forgalomirányítást.

Az OpenShift, amely eddig is natív támogatást nyújtott a Routes és Ingress erőforrásokhoz, most kibővíti ezt a támogatást a Gateway API-val, amelyet Istio alapokra épít. Fontos kiemelni, hogy a Gateway API használatához nincs szükség Service Mesh-re, azonban ha mégis használunk Service Mesh-t, akkor az OpenShift Ingress Operator kezeli a teljes életciklust: telepíti az Istio-t az OpenShift Service Mesh segítségével, menedzseli a DNS- és terheléselosztó (load balancer) konfigurációkat, valamint kezeli az Envoy-alapú gateway-t. Amennyiben harmadik féltől származó Gateway API implementációt használunk, a DNS- és terheléselosztó-menedzsmentet manuálisan kell elvégezni. A Gateway API nagyobb rugalmasságot ad a hagyományos Ingress API-hoz képest, lehetővé téve az összetett adatforgalom precíz szabályozását, miközben skálázható, jól megfigyelhető ingress menedzsmentet biztosít a modern, cloud-native munkaterhelésekhez.

AI terhelések optimalizálása dinamikus GPU szeleteléssel

Az OpenShift és a Red Hat OpenShift AI fejlesztése során kiemelt cél, hogy az ügyfelek innovatív megoldásokat kapjanak az AI megoldásaik bevezetéséhez, beleértve a gépi tanulási alkalmazásának (MLOps) teljes életciklusát, a modellfejlesztést, tanítást, finomhangolást, a generatív AI alkalmazását és egyéb AI feladatokat. Az OpenShift kiadás (4.19) két izgalmas, AI-hoz kapcsolódó újdonsága a dinamikus gyorsító-szeletelő (dynamic accelerator slicer) és a Red Hat build of Kueue.

A dinamikus gyorsító-szeletelő technológiai a jelen kiadásba technológiai előzetesként (technology preview) került be, vagyis kipróbálásra igen, de éles implementációra még nem ajánlott a használata. Lehetővé teszi a GPU-erőforrások igény szerinti dinamikus felosztását a workloadok követelményei alapján, így optimalizálva a GPU-kihasználtságot és csökkentve a költségeket. A dinamikus szeletelés kiváltja a statikus, előre felosztott erőforrás-kiosztást, amely gyakran kihasználatlan GPU kapacitásokhoz vezet, amennyiben a workload igényei nem illeszkednek az előre meghatározott GPU-partíciók méretéhez. A dinamikus gyorsító-szeletelő elsődleges felhasználási területe több LLM (nagy nyelvi modell) inferenciapéldány futtatása – például a Red Hat AI Inference Server használatával – egyetlen GPU-n, így támogatva a többbérlős (multi-tenant) környezeteket, ahol az egyes felhasználói csapatok megosztják a GPU-erőforrásokat a költséghatékony AI-fejlesztés, tesztelés és kiszolgálás érdekében.

AI műveletek egyszerűsítése intelligens feladatbesorolással

A Red Hat build of Kueue egy központosított, Kubernetes-native feladatbesoroló (queuing) komponens, amely intelligensen ütemezi, priorizálja és allokálja a klaszter erőforrásait a kvóták és az elérhetőség alapján a batch munkaterhelések kezelésére. Ez a komponens kezeli az erőforrás-ütközéseket azáltal, hogy a feladatokat sorba állítja, amíg elegendő számítási kapacitás, memória vagy GPU-erőforrás nem áll rendelkezésre, majd a feladatok befejeztével automatikusan visszaadja azokat az erőforrásokat a poolnak. A Red Hat build of Kueue elsődleges felhasználási területei közé tartozik a gépi tanulási tanítási pipeline-ok, nagy teljesítményű számítási (HPC) feladatok, valamint batchben futó feldolgozási feladatok kezelése többbérlős környezetekben, ahol a felhasználói csapatoknak igazságos erőforrás-megosztásra és prioritás-alapú ütemezésre van szükségük.

Összegzés

A Red Hat OpenShift 4.19 átfogó platformot kínál a modern vállalati igények kielégítésére, különös tekintettel az AI workloadok, a virtualizáció és a hálózati integráció területére. A platform új funkciói, mint például az OpenShift Lightspeed, a dinamikus GPU-szeletelés, a fejlett BGP-támogatás és az on-cluster image mód, lehetővé teszik, hogy a vállalatok hatékonyabban és rugalmasabban kezeljék alkalmazásaikat és virtuális gépeiket a hibrid felhő környezetekben.