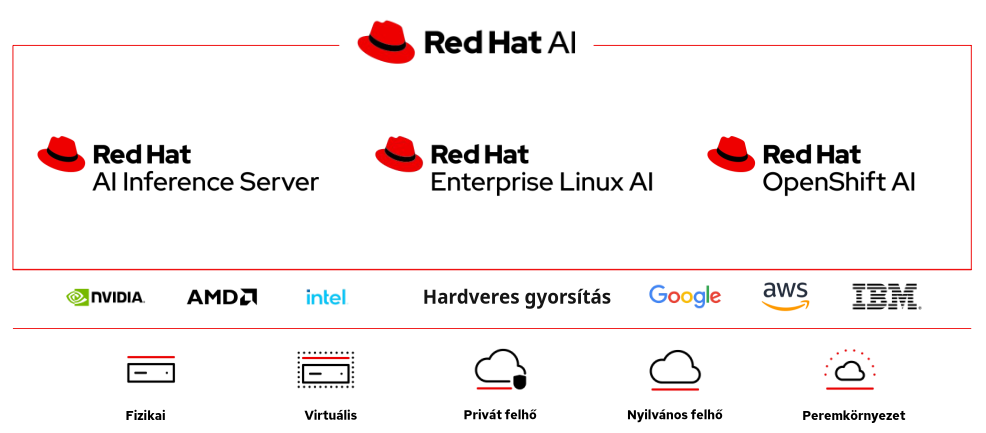

A 2025-ös Red Hat Summiton számos olyan bejelentés született, amelyek megerősítették a Red Hat vezető szerepét a vállalati mesterséges intelligencia (MI) megoldások terén. Az egyik ilyen kulcselem az egyre inkább teljesebbé váló Red Hat AI portfólió. A Red Hat AIa portfólió olyan nyílt forráskódú, hibrid felhőkörnyezetekre optimalizált termék- és szolgáltatáskészlet, ami lehetővé teszik a prediktív és generatív AI-modellek fejlesztését, finomhangolását, üzemeltetését és skálázását. A Red Hat AI portfólió három kulcsfontosságú terméke – a Red Hat Enterprise Linux AI (RHEL AI), a Red Hat OpenShift AI és a Red Hat AI Inference Server – szorosan együttműködik, hogy teljes körű AI-megoldásokat nyújtson a vállalatok számára. Az alábbiakban bemutatjuk, hogy hogyan egészítik ki egymást ezel a komponensek a különböző környezetekben, használati esetekben.

A Red Hat AI portfólió

A Red Hat AI portfólió lényege, hogy rugalmas, biztonságos és skálázható platformot biztosítson az AI-munkaterhelések kezelésére, kezdve a fejlesztéstől egészen az éles üzemeltetésig bezárólag. A portfólió nyílt forráskódú technológiákra – például a Granite modellekre, az InstructLab projektre és a vLLM keretrendszerre – épül, támogatja a hibrid felhőkörnyezeteket, beleértve a helyi adatközpontokat (on-prem), a privát- és nyilvános felhőkörnyezeteket (pl. AWS, Azure, Google Cloud) és a peremkörnyezeteket (edge).

A portfólió három fő elemre épül:

- Red Hat Enterprise Linux AI (RHEL AI): Egy AI-munkaterhelésekre optimalizált, bootolható operációs rendszer, ami a RHEL 10 alapjaira épül, integrálja a Granite modelleket és az InstructLab finomhangolási eszköztárat.

- Red Hat OpenShift AI: Egy Kubernetes-alapú MLOps platform, amely az AI-modellek teljes életciklusát kezeli, a fejlesztéstől a skálázható üzemeltetésig, különösen nagyvállalati környezetekben.

- Red Hat AI Inference Server: Egy vLLM-alapú inference (következtetési) megoldás, ami optimalizálja a generatív AI-modellek valós idejű futtatását, minimalizálva az ahhoz szüskéges erőforrásigényt.

Red Hat Enterprise Linux AI (RHEL AI)

A RHEL AI egy AI-központú operációs rendszer, amely a RHEL 10 image mode technológiájára épül, és bootolható, immutable konténerképeket biztosít. A platform integrálja a nyílt forráskódú Granite nagy nyelvi modelleket (LLM-ek), valamint az InstructLab eszköztárat, amely lehetővé teszi a modellek alacsony erőforrásigényű finomhangolását szintetikus adatgenerálással (Synthetic Data Generation, SDG) és Large-scale Alignment for Chatbots (LAB) technikával.

Legfontosabb jellemzői:

- Környezet: Egyedi Linux szerverekre vagy konténeres környezetekre optimalizált.

- Funkciók: Modellfejlesztés, finomhangolás, tesztelés és üzemeltetés; poszt-kvantum kriptográfia (PQC) és Secure Boot támogatás.

- Jellemző felhasználás: Pénzügyi intézet saját belső adatainak felhasználása a nyilvános chatbot rendszerének finomhangolására

Red Hat OpenShift AI

A Red Hat OpenShift AI egy Kubernetes-alapú MLOps platform, ami a Red Hat OpenShift konténerplatformra épül és az AI-modellek teljes életciklusát kezeli. A platform nyílt forráskódú projektekre, például a Kubeflow és az Open Data Hub alapul, támogatja a prediktív és generatív AI-modellek fejlesztését, képzését, üzemeltetését és monitorozását.

Legfontosabb jellemzői:

- Környezet: Nagyvállalati Kubernetes klaszterek, hibrid felhőkörnyezetek, edge és disconnected (air-gapped) környezetek.

- Funkciók: Adat-előkészítési pipeline-ok, modellszolgálás (KServe), drift-észlelés, AI guardrails, retrieval-augmented generation (RAG) támogatás.

- Jellemző felhasználás: Manufacturing vállalat prediktív karbantartási modellt futtat edge eszközökön egy OpenShift AI klaszter segítségével.

Red Hat AI Inference Server

A Red Hat AI Inference Server egy vLLM-alapú inference megoldás, amit a Neural Magic technológiáival optimalizáltak a generatív AI-modellek gyors és költséghatékony futtatására. A szerver önálló (konténerként futtatható) termékként, valamint a RHEL AI és az OpenShift AI részeként is elérhető.

Legfontosabb jellemzői:

- Környezet: Bármely GPU vagy CPU alapú környezet, hibrid felhők, edge.

- Funkciók: LLM Compressor a modellek tömörítésére, validált Hugging Face modellek, platformfüggetlen működés (NVIDIA, AMD, Intel).

- Jellemző felhasználás: Retail vállalat valós idejű ajánlórendszerének futtatása egy tömörített Llama modellen.

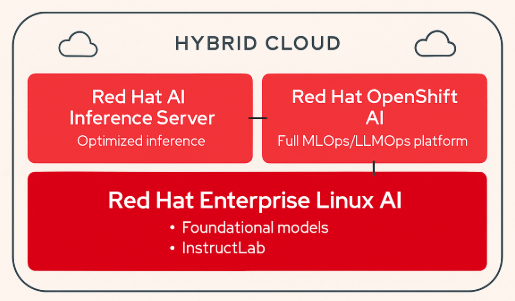

Hogyan egészítik ki egymást a platform komponensei?

A Red Hat AI portfólió komponensei szinergikusan működnek együtt annak érdekében, hogy teljes körű AI-megoldásokat lehessen kialakítani a használatukkal:

- A RHEL AI az az alap, ami önálló szervereken vagy kisebb környezetekben biztosít AI-képességeket, ideális a modellfejlesztéshez és teszteléshez.

- Az OpenShift AI skálázható, nagyvállalati környezetekre optimalizált, támogatja az MLOps pipeline-okat, például automatizált adat-előkészítést és modellmonitorozást.

- Az AI Inference Server a következtetési fázisra fókuszál, csökkentve az erőforrásigényt és növelve a sebességet, így mind a RHEL AI, mind az OpenShift AI környezetekben hatékonyabbá teszi a modellek éles üzemeltetését.